5.2. Способы анализа и интерпретации результатов тестирования

Необходимость разработки методов интерпретации вызвана стремлением выявить истинные различия в уровне знаний испытуемых, сравнить результаты между собой. Это стремление продиктовано достаточно серьезной причиной, связанной с тем, что «сырые» или тестовые баллы не дают информации о реальном уровне знаний. Интерпретация результата и его отнесение к категории плохих или хороших зависят от целого ряда факторов. Прежде всего, от того, как распределились результаты остальных испытуемых, от трудности и от количества заданий в тесте. Методы многофакторного анализа результатов тестирования являются средством объективной экспертизы содержательных компонентов качества образования и личностного развития: знаний, умений, навыков, творческого опыта учебной деятельности, ценностно–смыслового отношения к обучению, ключевых компетенций и др.

Адекватность интерпретации достигается путем сопоставления результатов анализируемой выборки или отдельного испытуемого с определенными нормами выполнения теста – множеством показателей, устанавливаемых эмпирически в процессе стандартизации теста. Соотнесение результата испытуемого с нормами выполнения позволяет установить, соответствует ли данный результат среднему или на сколько он выше или ниже среднего результата выполнения теста.

Наиболее удобным и показательным для представления статистических данных является метод графического анализа. Парные и множественные сравнения объектов наблюдения одного и того же или разных уровней проводятся по средним первичным или тестовым баллам, по медианным значениям или процентам выполнения заданий. Между собой могут сравниваться статистические данные нескольких объектов: классы в школе, школы в районе, районы в регионе и т. д. Ниже рассматриваются методы анализа информации с помощью гистограмм, графиков, прямоугольных и радиальных диаграмм успешности выполнения тестовых заданий.

Гистограммы. Для изображения распределения данных в широком диапазоне значений исследуемых характеристик анализируемых объектов широко используются гистограммы. Они обеспечивают наглядность распределения первичных и тестовых баллов на 100–балльной или 5–балльной шкале, позволяют сравнивать учебные достижения по различным массивам испытуемых.

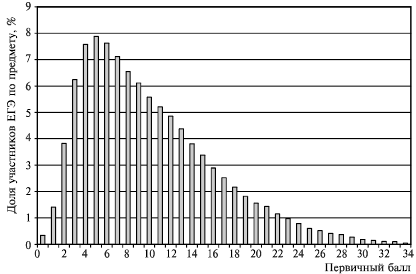

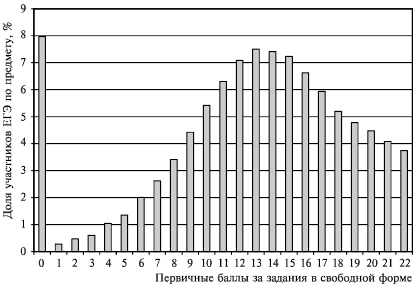

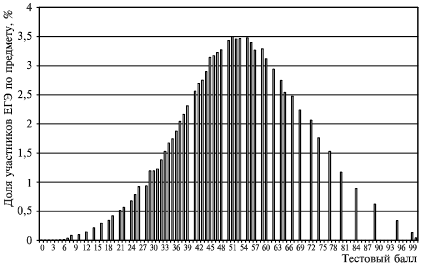

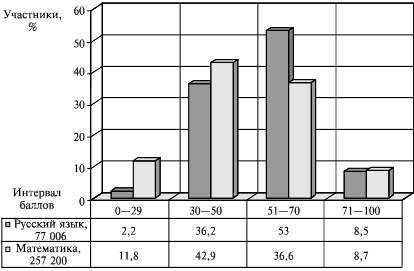

В гистограммах каждый столбик соответствует числу, проценту или доле участников, набравших соответствующий балл или балл в заданном диапазоне (диапазон баллов может быть по пяти, десяти или другому числу величины интервала). На гистограмме могут быть наглядно представлены максимальные и минимальные значения баллов исследуемой выборки; наибольшая высота столбиков показывает часто встречающиеся результаты, площади отдельных участков гистограммы дают представление о числе или доле участников, получивших отметки в том или ином диапазоне баллов. Это может быть распределение первичных баллов за весь тест (рис. 18) или за часть теста (рис. 19), тестовых баллов по любой выборке (рис. 20).

Иногда столбики гистограмм выделяют цветом или узором, обозначая различные уровни подготовленности испытуемых. В зависимости от целей анализа может быть выбран разный шаг баллов при построении гистограмм. На гистограмме по площади столбиков можно визуально оценить долю тестируемых, получивших как минимальные баллы (неаттестованных) – низкий уровень, так и максимальные – высокий уровень, а также долю учащихся со средним уровнем и вблизи него.

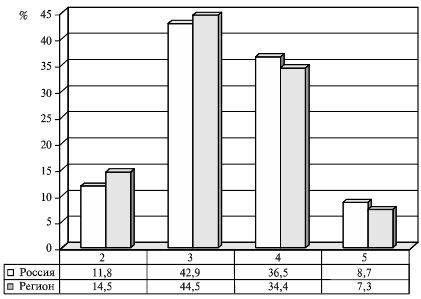

При помощи гистограмм можно проводить парные или множественные сравнения исследуемых характеристик для различных выборок испытуемых. Парные сравнения позволяют, например, учебные достижения исследуемой выборки сравнивать с данными генеральной (рис. 21) или отметки одной и той же выборки участников ЕГЭ по различным предметным областям или видам контроля (рис. 22).

Рис. 18. Распределение первичных баллов ЕГЭ по русскому языку, Россия

Рис. 19. Русский язык, первичные баллы за задания «С»

Рис. 20. Распределение тестовых баллов ЕГЭ по математике

Рис. 21. Распределение участников ЕГЭ по интервалам баллов

Рис. 22. Сравнение отметок по предметам

Как правило, гистограммы сопровождаются таблицами результатов, в которых могут быть указаны предметы и число участников экзамена; проценты участников, набравших соответствующий балл; можно сравнивать школьные отметки и результаты ЕГЭ по пятибалльной шкале и другие показатели.

По математике все выпускники экспериментальных регионов распределились так: низкий уровень (0—29 баллов) – 11,8%; ниже среднего (30—50 баллов) – 42,9%; средний уровень (51– 70 баллов) – 36,6% и высокий уровень (70—100 баллов) – 8,7%. По русскому языку – соответственно 2,2%; 36,2; 53,0; 8,5%.

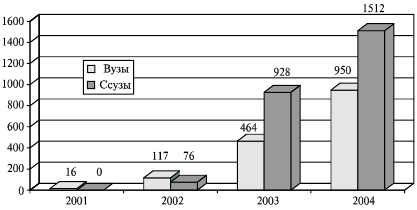

На гистограммах множественные сравнения позволяют сопоставлять по выделенному свойству несколько выборок между собой по годам, категориям, типам образовательных учреждений и другим данным (рис. 23).

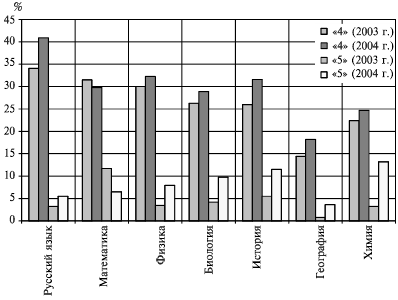

Достаточно наглядно можно представлять на гистограмме (рис. 24) динамику изменений отметок по разным предметам по годам, территориям или образовательным учреждениям.

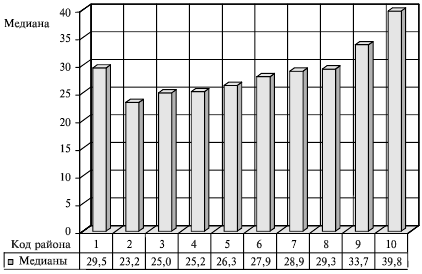

Медианный анализ при помощи гистограмм (рис. 25) позволяет наиболее корректно сравнивать результаты, давая представление о качестве подготовки большого числа различных выборок испытуемых.

Рис. 23. Динамика участия вузов и ссузов в ЕГЭ по годам

Рис. 24. Сравнение отметок «4» и «5» по ЕГЭ 2003—2004 гг. в регионе

Рис. 25. Значения медиан первичных баллов по математике разных районов

Медианой называют среднее значение отранжированного ряда результатов (тестовых баллов), которое делит весь ряд на две равные части. Обучающиеся одной половины имеют баллы выше медианы, условно назовем ее «сильной», а учащиеся второй половины, «слабой», имеют баллы ниже медианы. Расчет медианы me при четном количестве учащихся (N = 2k) проводится по формуле

а при нечетном (N = 2k + 1) медиана me = Хк+1 , где N – общее число объектов наблюдения, а k – их середина (половина). Медианы используют как дополнительную информацию к гистограммам распределения тестовых баллов, так как именно они позволяют в компактной форме наглядно представить и характеризовать плотность распределения баллов сильной и слабой половины учащихся.

Линейные графики. Линейные графики достаточно хорошо иллюстрируют рейтинги различных объектов наблюдения, они удобны для оценивания рейтинга общеобразовательных учреждений разных типов, рейтинга территорий, классов в школе, выпускников, когда требуется установить их последовательность по анализируемому свойству. На линейных графиках можно проводить сравнения большого числа объектов однотипного ряда (одна зависимость), по разным уровням обобщения данных или временным интервалам.

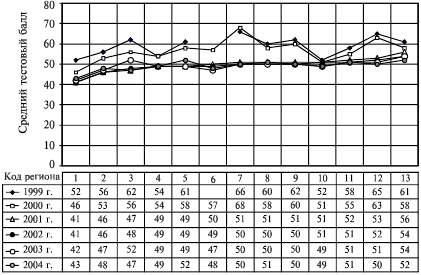

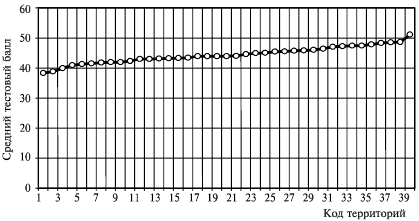

Такие сравнения, проведенные за несколько лет, позволяют более объективно выявлять закономерности развития образовательных систем. Для динамического мониторинга рейтинг однотипных объектов (например, регионов) за несколько лет можно представить совокупностью линейных зависимостей на одном графике (рис. 26). Как видно из графика, по результатам централизованного тестирования за ряд последних лет наблюдается стабильность значений средних тестовых баллов по регионам (указаны условные коды). В данном случае для анализа выбраны средние тестовые баллы региона, рассчитанные по сумме всех предметов и всех участников тестирования, в результате анализируются «средние тестовые баллы региона».

Рис. 26. Рейтинг регионов по результатам централизованного тестирования (средние тестовые баллы всех участников региона по сумме всех предметов

Это позволяет показать прогностические возможности такого подхода к оценке качества обучения в разных территориях страны, а уж затем разбираться в причинах успехов или неудач. Выбор регионов (табл. 8) сделан из формируемого ФЦТ рейтинга пошаговым смещением от самого высокого до самого низкого значения рейтинга с интервалом в 10 позиций [192].

Таблица 8

Динамический анализ показывает, что устойчиво обнаруживается территориальный фактор (сохранение рейтинга регионов). По всей видимости, это связанно как с особенностями систем управления, так и другими специфическими условиями и причинами для данной территории. Использование Центром тестирования в 1999 и 2000 гг. однопараметрической математической модели Г. Раша для создания КИМов давало более высокий тестовый балл и большие расхождения баллов по регионам. В какой–то степени это также могло быть связано и с малым числом участников тестирования в первые годы и неподготовленностью школьников к такого рода оценочным процедурам (нерепрезентативностью выборки). Общее снижение тестового балла в 2001—2004 гг. обусловлено не резким понижением успеваемости, а использованием КИМов и пересчетом баллов по двухпараметрической модели Бирнбаума.

Видно, что за 2001 и 2004 гг. рейтинг регионов, рассчитанный по средним тестовым баллам совокупности всех предметов и тес–тируемьгх, практически не изменялся. Устойчивость рейтинга характерна практически для всех регионов, выбранных для анализа, что свидетельствует о правомерности сравнительного анализа. Наибольшая разность между крайними значениями средних тестовых баллов составила: 11 – в 1999 г.; 17 – в 2000 г.; 15 – в 2001 г.; 13 – в 2002 г.; 12 – в 2003 г.; 9 – в 2004 г. Снижение этой разности обусловлено как совершенствованием технологии тестового контроля, так и подготовкой школьников к независимой аттестации.

Корректность педагогического анализа в данном случае требует не давать однозначную оценку качеству учебных достижений выпускников в этих регионах по многим причинам: разное число участников тестирования, а следовательно, несопоставимость условий контроля; нерепрезентативность выборки в условиях добровольности участия в тестировании; несовершенство тестовых материалов, процедур тестирования и методик шкалирования и др. Кроме того, следует отметить, что для эффективного функционирования контрольно–оценочной системы в учебных заведениях пока еще нет необходимого методического и технологического обеспечения, ощущается нехватка инструментальных средств контроля и анализа его результатов, контрольно–обучающих программ, математико–статистических пакетов для обработки результатов контроля и компьютерных классов с сетевым оборудованием, разная готовность педагогов к работе с тестами. Пока больше можно говорить о возможностях подобного анализа и перспективности его применения после преодоления целого ряда трудностей, связанных с развитием массового тестирования и введением единого государственного экзамена. И все же некоторые выводы можно сделать уже сейчас.

Во–первых, разница в качестве подготовки по регионам существует, и ее можно измерять, так как тестирование проводилось в одинаковых условиях (время, КИМы, длительность работы, автоматизированная проверка, методика шкалирования), а число участников в каждом регионе было достаточным, чтобы зафиксировать общие тенденции изменений за последние годы.

Во–вторых, интервал средних тестовых баллов между самым успешным и самым слабым регионом не является критичным, особенно в 2004 г. При всех возможных различиях обучения в разных регионах базовая составляющая в значительной степени обеспечивается на достаточном уровне в каждом из них.

В–третьих, детальный предметный анализ показывает, что в одних регионах сильнее проявляется подготовка по гуманитарным дисциплинам, а в других – по естественно–научному циклу. Средние тестовые баллы по России в целом задают статистические нормы для критериев успешности функционирования различных образовательных систем.

В–четвертых, в большинстве случаев нет большого разрыва между достижениями городских и сельских школ. Очевидно, что традиционные формы контроля ранее не позволяли обнаружить совокупность этих факторов.

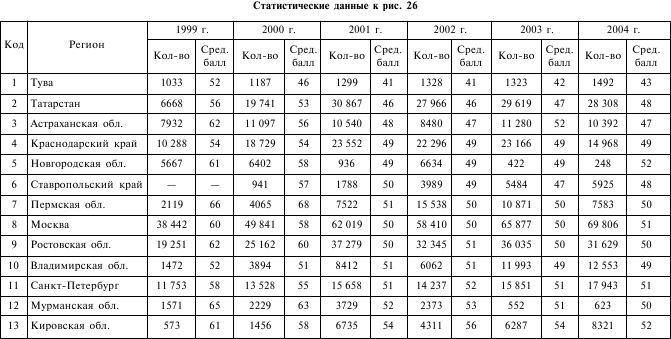

О качестве регионального образования по тому или иному предмету в том или ином регионе можно судить по плотности распределения учащихся, набравших соответствующие тестовые баллы, в сравнении с таковым для всех выпускников России (рис. 27).

При этом следует учитывать, что надежность и точность педагогических измерений выше там, где больше плотность участников, а следовательно, в центральной части распределения. В интервалах баллов от 0 до 20 и от 75 до 100 могут быть значительные погрешности из–за малого числа выпускников, попадающих в эти интервалы. Однако достаточно хорошо видно, что результаты анализируемой выборки коррелируют с данными по России.

На рис. 28 для показа возможностей линейных графиков приведен рейтинг отдельных территорий региона ЕГЭ по математике по средним значениям тестовых баллов, которые для данных объектов находятся в диапазоне от 38 до 53, а размах баллов составляет 15, почти на треть баллы слабой территории ниже, чем сильной.

Рис. 27. Плотность распределения учащихся, набравших соответствующий тестовый балл по математике: – о– Россия; —О– регион

Рис. 28. Математика, ЕГЭ

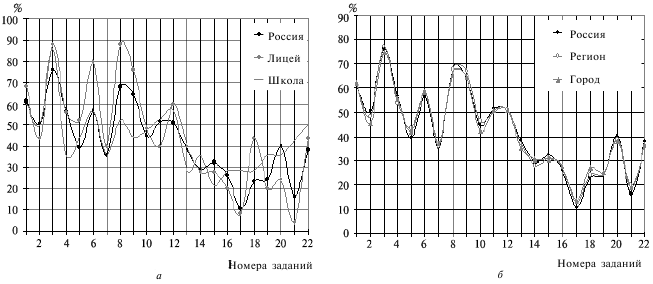

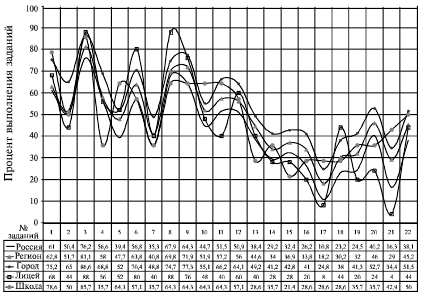

Сравнительный анализ результатов массового тестирования позволяет выделять те или иные факторы, имеющие место в образовательной системе. К примеру, некоторые из факторов оказывают одинаковое влияние на результат всех участников тестирования (образовательная политика в стране, стандарты, содержание КИМов и др.), а часть из них могут носить случайный характер и оказывать разное воздействие на индивидуальный результат испытуемых. Cлучайные факторы оказывают сильное влияние на общий результат малых выборок тестируемых (рис. 29, а; лицей – 24 человека; школа – 43 человека). В силу рандомизации, при статистически достаточном числе испытуемых влияние случайных факторов на общий результат выборки исключается (рис. 29, б; Россия – более 600 тыс. человек; регион – около 40 тыс. человек; город – около 10 тыс. человек).

Такие данные можно использовать в качестве статистической нормы (генеральная выборка). Для объективизации выводов и заключений педагогический анализ результатов массового тестирования следует проводить в сравнении с данными генеральной выборки (учащиеся страны, региона или крупного города). В этом случае при выявлении причин успехов или неудач образовательной деятельности обеспечивается большая объективность выводов, заключений и принимаемых решений.

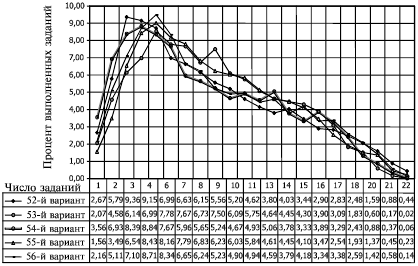

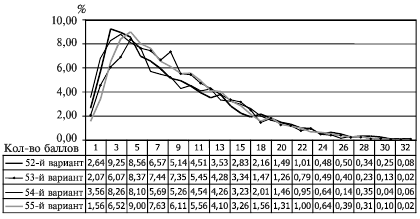

Метрические свойства контрольных измерительных материалов обеспечивают сопоставимость баллов, полученных при выполнении учащимися разных вариантов теста. На рис. 30 представлена в процентах доля участников ЕГЭ, выполнивших то или иное число заданий и набравших соответствующее число первичных баллов по математике по различным вариантам тестов (без учета заданий «С»). Задания «А» и «В» оценивались дихотомически, а следовательно, число выполненных заданий равно числу првич–ных баллов.

Сравнительный анализ элементов диаграммы позволяет оценить степень равноценности трудности использованных вариантов КИМ по математике ЕГЭ. Каждый вариант выполняли 2500—3000 выщскников в различных школах региона, что полностью обеспечивает репрезентативность результатов. Видно, что максимум участников приходится на 3—6 выполненных заданий, что соответствует границе между «двойкой» и «тройкой» на шкале школьных отметок. По числу участников, выполнивших от 1 до 13 заданий, заметна существенная разница по вариантам.

Рис. 29. Выполнение заданий теста по математике (сравнение с данными по России): а – влияние случайных факторов;

б – рандомизация

Рис. 30. Сравнительный анализ трудности вариантов по математике (задания «А» и «В»)

На рис. 31 приведены результаты с учетом выполнения заданий «С», оцениваемых политомически (разные баллы за разные задания). Первичный балл при шкалировании результатов ЕГЭ рассчитывался по правилу: за каждое выполненное задание из области «А» (с выбором ответа) и «В» (со свободным ответом) учащийся получал по одному баллу, а за каждое выполненное

Рис. 31. Сравнительный анализ трудности вариантов экзаменационных заданий ЕГЭ по математике (с учетом заданий «С»)

задание из области «С» (со свободным конструированием ответа) – по четыре балла. Таким образом, максимальный первичный балл за весь тест равен 34. Вид кривых несколько иной и показывает, что чем лучше подготовлены учащиеся к экзамену, тем меньше зависимость их баллов от варианта теста.

Следует таже учитывать, что технология обработки результатов ЕГЭ предполагает введение персичного балла только на первой стадии расчета, затем тестовый балл рассчитывается с учетом уровня трудности выполненных заданий. В окончательных протоколах указывается индивидуальный тестовый, который выдается выпускникам в свидетельствах ЕГЭ.

Таким образом, сравнительная оценка вариантов тестов позволяет считать их в приемлемой степени равно трудными и анализировать степень овладения школьниками навыками решения задач различного уровня трудности. Особенно важно отметить, что предоставляется возможность оценки базового уровня знаний и умений, от которого в конечном счете зависят успехи в решении более сложных задач, а также дифференциация выпускников по уровням подготовленности в широком диапазоне баллов.

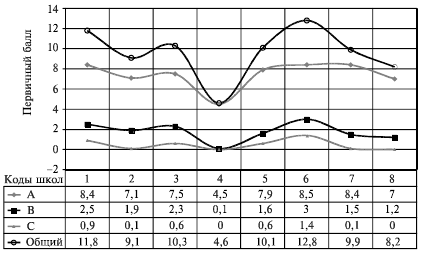

При помощи линейных графиков, совмещенных с таблицами данных (рис. 32), можно сравнивать достижения различных школ по разным видам заданий теста, тем самым выявляя разное количество подготовленных школьников.

Рис. 32. Средние первичные баллы по математике в разных школах за различные виды заданий

Умения школьников решать задачи повышенного уровня достаточно хорошо коррелируют с базовыми знаниями: в школах, где учащиеся выполняли задания «В» и «С» выше средний первичный балл за задания «А». На графике наиболее слабая подготовка по математике наблюдается у школы с кодом 4, выпускники которой выполняли только задания «А», а наиболее качественная – у школы с кодом 6. Такой анализ дает представление не только о качестве знаний школьников, но и квалификации педагогов. Если ни один из учеников не выполнил ни одного задания «В» и «С», то это уже сигнал для руководства школы к изменению организации обучения.

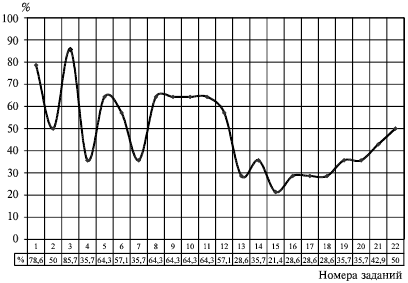

Все варианты стандартизированного теста, как правило, имеют одинаковую содержательную стуктуру и близкие по уровню трудности задания по указанным темам. Поэтому анализ правильных ответов по каждой выборке дает учителю ценную информацию о структуре усвоенных знаний по темам; для этого учителям необходимо анализировать проценты выполнения заданий теста (рис. 33).

Массовое тестирование учащихся, несомненно, оказывает положительное влияние на деятельность школ. Наличие независимых оценочных процедур заставляет педагогов более строго подходить как к оцениванию знаний школьников, так и к своей дея

Рис. 33. Процент выполнения тестовых заданий учащимися школы

тельности, более внимательно пересматривать образовательные программы и методики обучения, использовать документацию на КИМ (спецификации, структуру демотестов, справочные данные и инструкции) при составлении рабочих программ и использовании методов контроля в текущей оценочной деятельности. Однако правильные выводы можно сделать только при сравнительном анализе, отдельно взятая зависимость в данном случае не дает учителю полной информации о качестве подготовленности школьников.

Необходимая информация появляется только при сравнении исследуемой выборки с нормой – среднестатистическими результатами генеральной выборки или другими репрезентативными выборками (регион, город) (рис. 34). Проводя сравнение тестовых баллов и процентов выполнения заданий школьников со среднестатистическими оценками генеральной выборки, учителя получают возможность корректировать свои критерии оценивания знаний школьников в текущей работе.

Поясним это на примере. Положим, что учащиеся исследуемой выборки одно из заданий выполнили на 40%, а второе – на 75%. Какая из тем ими усвоена лучше? Проще всего ответить – та, для которой процент выполнения выше. Действительно, ана

Рис. 34. Множественное сравнение результатов выполнения теста

лизируя эти данные без сопоставления с нормой, учитель делает вывод, что учащиеся усвоили вторую тему лучше, чем первую. Однако такой вывод является ложным, если на генеральной выборке процент выполнения первого задания составит 25, а второго 95.

Это значит, что школьники исследуемой выборки хорошо усвоили именно первую тему, представленную в тесте заданиями высокого уровня трудности, и показали результат на 15 пунктов выше нормы. Задания второй темы были легкими, их на уровне генеральной выборки могли решить практически все школьники, но эта тема не была достаточно изучена (упущена) школьниками исследуемой выборки, а поэтому процент правильно выполненных заданий оказался на 20 пунктов ниже, чем на генеральной выборке. Без учета уровня трудности тестовых заданий ответить на такой вопрос невозможно. Распределение заданий теста по трудности достаточно наглядно может быть представлена графиком процентов выполнения заданий всей совокупностью испытуемых.

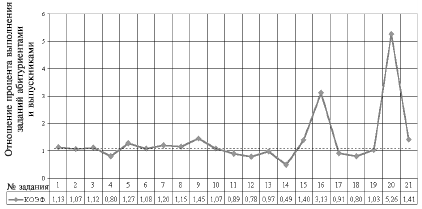

В июле, на втором этапе экзамена в форме и по материалам ЕГЭ – на так называемой вузовской волне, результаты, как и следует ожидать, несколько выше, чем при аттестации основной массы выпускников. Для наглядности относительный коэффициент подготовленности абитуриенов можно получить как отношение процентов выполнения заданий теста абитуриентами к процентам его выполнения выпускниками (рис. 35).

Рис. 35. Относительный уровень подготовленности абитуриентов по математике

Радиальные диаграммы. Уровни трудности заданий или затруднений (успешности) учащихся представляются в виде графика, на котором по горизонтальной оси отложены номера заданий теста, а по вертикальной – проценты правильно выполненных заданий.

Следует учитывать, что с учетом статистического веса трудности тестовых заданий гистограмма на 100–балльной шкале не имеет столь прозрачного толкования, как на шкале первичных баллов (числа выполненных заданий), она требует указания критериев оценивания. Такой график предназначен для анализа тематической структуры усвоения содержания учебной дисциплины как отдельным испытуемым, так и на уровне класса, школы, района и т.д. На различных выборках в сравнении с генеральной оценивается уровень затруднений или успешности обучения обучающихся или отдельных классов. Визуально проявляются особенности образовательного процесса, что позволяет судить об уровне содержательной подготовленности учащихся исследуемого объекта (класс, школа и т.д.). Спектр возможных сравнений на радиальных диаграммах может быть таким же широким, как и на других графиках, но, кроме того, такой способ представления информации является не только более наглядным, но и компактным. Для анализа усвоения содержания учебных дисциплин удобно пользоваться радиальными диаграммами, на которых по окружности даны номера тестовых заданий, а по радиусу – проценты правильных ответов.

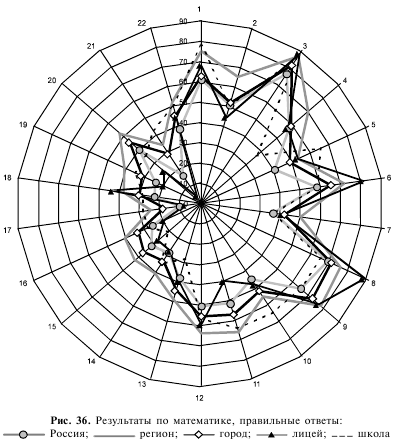

Пример множественного сравнения результатов централизованного тестирования выпускников по математике приведен для нескольких выборок одновременно (рис. 36). Выборочная совокупность выпускников, сдававших математику, составила: по России – 211 556 человек (около 17% общего числа выпускников); в регионе – 10 867 человек, или 25%, в городе – около 4000 человек, или 45%, что в достаточной степени обеспечивает репрезентативность и рандомизацию результатов. Каждая из них может быть использована в качестве нормы для определения уровня учебных достижений образовательного учреждения.

Для больших выборок (Российская Федерация, регион, город) в силу рандомизации результатов наблюдается синхронность кривых в соответствии с уровнем трудности тестовых заданий, однако количественные данные несколько различаются. Видно, что подготовка школьников региона по математике несколько выше, чем по России в целом. Содержательные структуры учебных достижений выпускников лицея с профильной подготовкой по математике и обычной школы существенно от

личаются как между собой, так и относительно данных России, региона и города. Такая информация полезна для педагогических коллективов при анализе «болевых точек» учебного процесса и его корректировке. Рассмотренный способ графического содержательного анализа обладает высокой степенью информативности. Еще одной его особенностью является то, что площадь, охваченная кривой на диаграмме успешности, задает в условном выражении долю знаний, усвоенных данной выборкой учащихся.

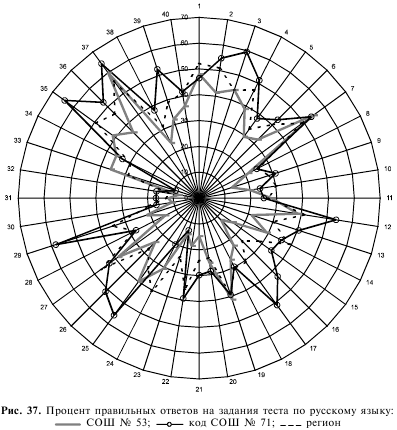

Аналогичные диаграммы по результатам массового тестирования можно строить и анализировать по всем дисциплинам для разных категорий учащихся, а также по видам итоговой аттестации (рис. 37).

Синхронность хода кривых отражает несколько моментов: во–первых, объективную сложность предмета; во–вторых, структуру уровней трудности тестовых заданий разных по годам тестов; в–третьих, достаточно стабильный уровень подготовки учеников по годам на данной территории; в–четвертых, близкие значения результатов по России и региону.

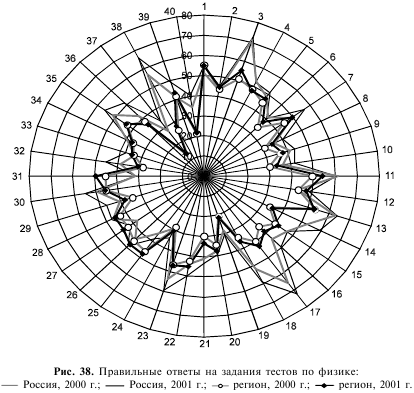

Отметим, что результаты анализа структурированности знаний учащихся выпускных и других классов по результатам тестового контроля могут представлять интерес не только для учителей, но и для разработчиков тестов и методистов – организаторов ЕГЭ. На рис. 38 видно, как меняется структура трудности тестовых заданий разных по годам тестов по физике, использованных для централизованного тестирования.

Такие и многие другие сравнения в условиях многоуровневого квалиметрического мониторинга возможны по любым территориям, выборкам школьников, учебным дисциплинам, образовательным учреждениям и другим параметрам в соответствии с целями и задачами конкретного мониторингового исследования. Сопоставление результатов обучающего тестирования за определенный промежуток времени дает возможность оценивать динамику развития конкретной группы школьников или отдельного обучаемого, раскрывает реальные возможности индивидуализации траекторий обучения отдельных учащихся на основе анализа процентов выполнения тестовых заданий и дихотомических таблиц результатов различных видов массового тестирования.

Использование методов многофакторного анализа результатов тестирования может служить надежным средством экспертизы содержательных компонентов качества подготовки учащихся, а дополнительные процедуры педагогических измерений – средством определения корреляции личностных качеств испытуемых с качеством предметной подготовленности. В этом смысле фронтальное тестирование всех выпускников страны на едином государственном экзамене может рассматриваться как база информационного многоуровневого квалиметрического мониторинга учебных достижений и личностных характеристик выпускников. В настоящее время только формируются система, структура и содержание единого государственного экзамена, отрабатываются формы его проведения, а соответственно, в стране только создаются условия для организации нового средства управления качеством образования и образовательным процессом.

В связи с этим появляются условия для создания целостной и комплексной общероссийской системы мониторинга качества образования, основанной на современных универсальных методах тестового контроля и открывающихся возможностях наблюдения за всей системой общего образования и ее отдельными составляющими на основе метрической образовательной информации, не зависящей от индивидуальных оценочных подходов учителя. С учетом этой важнейшей функции тестирования строится система современного многоуровневого квалиметрического мониторинга и основанная на нем система диагностики и экспертизы качества образования, вписывающихся в систему современного маркетинга образовательных услуг.

Мониторинг качества подготовленности учащихся в той или иной предметной области средствами педагогического тестирования ориентирован, с одной стороны, на точное отражение в тестах современного содержания образования (образовательных стандартов), а с другой – на возможность измерения знаний во всем комплексе их количественных и качественных характеристик. Одной из задач такого мониторинга становится обеспечение большого числа пользователей (учащиеся, учителя, родители, работники управления образованием и др.) постоянным потоком сопоставимой информации о качестве учебных достижений школьников на основе анализа результатов тестового контроля. Развивающиеся технологии массового тестирования все заметнее начинают оказывать влияние на образовательную практику школ и деятельность органов управления образованием. Поэтому очень важной становится научно обоснованная интерпретация результатов массовых контрольно–оценочных процедур. В полной мере это относится ко всем составляющим компонентам технологии проведения ЕГЭ – от разработки КИМов, до процедуры проведения экзамена, проверки работ, обработки результатов, шкалирования и оценивания учебных достижений, их содержательного анализа.

Для проведения содержательного анализа результатов тестирования каждую предметную область учебной деятельности будем рассматривать как информационную систему, состоящую из определенной суммы учебных элементов. Тестовые задания разрабатываются таким образом, чтобы охватить содержание каждого блока и наиболее важных учебных элементов, составляющих эти блоки. Поэтому по статистическим данным успешности решения каждого тестового задания можно определять качество усвоения не только курса в целом, но и каждого блока, а в нем – тех элементов знаний, которые запрограммированы в данном тестовом задании. При содержательном анализе результатов тестирования предметную область любой дисциплины, отраженную в системе тестовых заданий, и информационное поле ее усвоения можно классифицировать не только по указанным выше блокам, но и по структурным элементам: знание основных понятий и законов; знание процессов и классификаций; знание фактического материала; практическое применение знаний и др. Это предоставляет возможность получения подробных сведений о структуре знаний тестируемых.

Возможное возражение по поводу объективности данного анализа можно снять за счет того, что в тестах дается достаточно большое число заданий с различным уровнем трудности, а в связи с этим наблюдается различный процент (уровень) решаемости или нерешаемости тех или иных заданий. В настоящее время уровень трудности заданий определяется заранее, учитывается при шкалировании и выставлении баллов. Кроме того, во время апробации проводится отбраковка тех тестовых заданий, которые из–за неудачной формулировки или превышения порога трудности редко выполняются испытуемыми. Таким образом, вероятность включения в тест какого–либо особо «нерешаемого» тестового задания незначительна. Во всех вариантах тестов под одним и тем же номером размещаются тестовые задания, программирующие содержание одного и того же учебного элемента (так называемые параллельные или близкие к параллельным тестовые задания), что существенно облегчает содержательный анализ и интерпретацию результатов тестирования.

В процессе оценивания качества подготовленности обучающихся можно выявить в неявной форме тенденции в проявлении тех или иных позитивных качеств обучаемых из числа перечисленных выше. Без сомнения, сам факт правильного выполнения трудного задания без помощи и подсказки уже является свидетельством проявления позитивных качеств личности обучаемого. Если же среди выполненных верно заданий преобладают трудные, требующие упорства, то это подтверждает наличие таких качеств обучаемого, как целеустремленность, настойчивость, терпение. Таким образом, если содержание заданий допускает помимо прямой оценки и дополнительную интерпретацию, нацеленную на выявление латентных характеристик личности обучаемого, то можно получить интегральную характеристику качества его подготовленности.

Более 800 000 книг и аудиокниг! 📚

Получи 2 месяца Литрес Подписки в подарок и наслаждайся неограниченным чтением

ПОЛУЧИТЬ ПОДАРОК